Jos tekoäly on uusi sähkö, kuka takaa, ettei se tule kynsille? Algoritmit ohjaavat sitä, mikä ennen oli ihmisten tekemien valintojen piirissä: autoja, mediasisältöjä, rahaliikennettä, laitteistoja, tuotantokoneistoja ja robotteja.

Valtava kiinnostus tekoälyyn on onneksi poikinut keskustelua riskeistä ja eettisistä ongelmista. Silti tekoälyn etiikan pohdinnassa ollaan vasta alkutekijöissä.

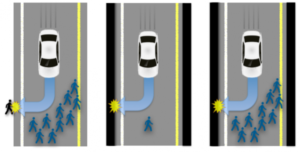

Nyt keskustellaan esimerkiksi robottiauton toiminnasta vaikeissa valintatilanteissa. Pitäisikö robottiauton törmätä kahteen jalankulkijaan vai kääntää ohjausta ja osua vain yhteen kadun toisella puolella (esim. Kalra & Paddock 2016)?

Ongelma on kuitenkin vaikea lähinnä siksi, että emme osaisi vastata siihen silloinkaan, jos itse istuisimme ratin takana. Emme yksinkertaisesti osaa kertoa tekoälylle, miten sen tulisi toimia.

Paljon merkittävämpi tekoälyn etiikan haaste on sen lisääntyvässä kyvyssä oppia. Tekoäly kykenee kehittämään uusia sääntöjä, joiden mukaan toimimalla se pyrkii sille annettuun päämäärään, tai keksimään itselleen aivan uusia päämääriä.

Tekoäly voi näin oppia toimimaan tavoilla, jotka eivät kestä eettistä tarkastelua. Pankkien lainapäätöksiä tekevä tai tuomareille tuomioita suositteleva tekoäly voi alkaa kuin huomaamatta päätellä, että tietyllä alueella asuvilla on suurempi todennäköisyys jättää lainansa maksamatta tai syyllistyä uuteen rikokseen (ks. Boström & Yudkowsky 2011).

Kun tekoetiikka ei riitä

Helposti voisi ajatella, että tekoälylle pitäisi siis opettaa “tekoetiikkaa”: koodata eettisiä sääntöjä, joita sen tulee noudattaa. Rangaistus tai lainapäätös ei saa riippua asuinalueesta.

Ajatus kohtaa kaksi suurta ongelmaa.

Jotta voimme opettaa eettiset käsityksemme tekoälylle, meidän täytyy tietää, millä perustein se tekee ratkaisunsa.

Oppivat tekoälyt kuitenkin esimerkiksi kehittävät algoritmeja, joiden tavat päätyä haluttuihin lopputuloksiin muuttuvat nopeasti ihmiselle käsittämättömiksi. Puhutaan “mustan laatikon” ongelmasta.

Toinen ongelma on, että eettisten käsitysten muuttaminen tekoälylle sopivien algoritmien muotoon voi osoittautua mahdottomaksi. Vaikka tässä onnistuttaisiinkin, mikä tahansa etiikan näkemys on avoin vastaesimerkeille – tilanteille, joissa sen seuraaminen johtaa eettisesti kyseenalaiseen lopputulokseen.

Tekoälyn pitäisi siis myös tunnistaa eettisiä ongelmia ja punnita vaihtoehtoja – kyetä eettisen oppimisenkaltaiseen toimintaan.

Puhuva laatikko?

“Mustan laatikon” ongelman ratkaisuksi on jo pitkään tarjottu tekoälyn prosessien läpinäkyvyyttä. Mutta vaikka kaikki tekoälyn kehittämät toimintamallit olisivat periaatteessa avoimesti tarkasteltavissa, ihmisjärjen on vaikea seurata ja ymmärtää pitkälle oppineen tekoälyn suorittamaa “päättelyä”. Se veisi yksinkertaisesti liikaa aikaa.

Ratkaisu ongelmaan voi löytyä tekoälystä itsestään, jos edellytämme, että tekoälyn on kyettävä selittämään päättelynsä ihmiselle – ainakin silloin, kun sitä päätöksenteossa käyttävä ihminen ei sitä kykene ymmärtämään.

Ihmisten kannalta merkityksellisiä päätöksiä tekevän tai suosittelevan tekoälyn täytyy kyetä kertomaan ihmiselle, millä perustein se tekee ratkaisunsa.

Voimakkaan läpinäkyvyyden vaatimuksen toteutuminen mahdollistaisi tekoälyn toiminnan arvioinnin ja opettamisen. Tekoälyn on kyettävä ymmärrettävään viestintään ihmisen kanssa.

Tekoäly, tekotunneäly?

Toinen ongelma on jopa visaisempi. Vaikka kykenisimme opettamaan tekoälylle eettisiä nyrkkisääntöjä hieman kuin lapselle, säännöt eivät voi kattaa kaikenlaisia eteen tulevia tilanteita.

Tekoälyn pitäisi kyetä myös havaitsemaan sen noudattamien eettisten sääntöjen ongelmia ja korjaamaan “käsityksiään”. Mutta miten tämä olisi mahdollista?

Yksi tapa yrittää vastata ongelmaan on vaatia, että merkityksellisiä päätöksiä tekevän tekoälyn on huomioitava ihmisten tunteet ja opittava niistä.

Eettisten käsitysten kehittyminen ja korjaaminen perustuu usein tunteisiin. Vaikka perustavat arvomme ja toimintamme eettiset periaatteet on opittu lapsuudessa, todellisten tapahtumien, fiktion ja kuvitelmien herättämät tuntemukset saavat meidät arvioimaan toimintaamme uudestaan. Tunteet toimivat tässä mielessä etiikan aineistona (ks. Rydenfelt 2015, 2017).

Toisin kuin Westworldin tiedefiktiossa, tekoäly tuskin koskaan muuttuu itse tuntevaksi tai aitoon empatiaan kykeneväksi toimijaksi. Mikään ei kuitenkaan estä tekoälyä käyttämästä ihmisten tunnereaktioita omaan ja toistensa toimintaan datana, jonka valossa se muodostaa ja korjaa eettisiä käsityksiään.

Tekoälyn on mahdollista kehittyä myös (teko)tunneälyksi.

Oppiakseen etiikkaa tunteiden avulla tekoälyn pitäisi seurata ja jopa muuttua osaksi sosiaalista toimintaa. Paljon riippuu myös seurasta. Psykopaatin tai pahasta addiktiosta kärsivän ihmisen tunnereaktioihin eettisen oppimisensa perustava tekoäly “kasvaisi kieroon”.

Työsarka tekoälyn kehittäjille, tutkijoille ja filosofeille on jälleen valtava, vaikka tuskin aivan mahdoton.

Ja paljon muita haasteita

Läpinäkyvyyden sekä “tunneälyn” vaatimukset voivat osaltaan vastata käsillä oleviin haasteisiin, joita oppivan tekoälyn tuominen osaksi päätöksentekoa aiheuttaa.

Pidemmälle kehittyessään tekoäly tuottaa kuitenkin myös aivan toisentyyppisiä eettisiä ongelmia, jotka liittyvät sen omaan asemaan yhteiskunnassa.

Yksi kysymys koskee tekoälyn omia eettisiä oikeuksia. Voiko tekoäly kehittyä niin pitkälle, että ihmisillä on sitä kohtaan velvollisuuksia? Pitäisikö sen myös voida omistaa omaisuutta, äänestää tai lisääntyä?

Toinen haaste ei ole pelkästään eettinen vaan voi koskea koko olemassaoloamme. Filosofit ja muut tutkijat ovat jo vuosikymmeninä esittäneet visioita “superälystä”, joka ohittaa ihmisen kyvyt joka saralla (Chalmers 2010).

Jos superäly toteutuu, toivoa sopii, että sen eettinen näkemys ihmisistä on vaativampi kuin meidän suhtautumisemme moniin vähäisemmällä älyllä varustettuihin lajeihin.

Ehkä superälyllä on myös supertunneäly.

Viitteet

Boström, Nick & Eliezer Yudkowsky (2011). The Ethics of Artificial Intelligence. Teoksessa William Ramsey & Keith Frankish (toim.) Cambridge Handbook of Artificial Intelligence. Cambridge University Press, Cambridge.

Chalmers, David (2010). The Singularity: A Philosophical Analysis. Journal of Consciousness Studies. 17:7–65.

Kalra, N., & Paddock, S. M. (2016). Driving to Safety. Rand Report.

Rydenfelt, Henrik (2015). Emotional Interpretants and Ethical Inquiry. Sign System Studies 43:4, 501–13.

Rydenfelt, Henrik (2017). Habits, Purposes and Pragmatism. Teoksessa M. Švantner & V. Gvoždiak (toim.) How to Make Signs Clear: Sources, Problems and Limits of Peirceʼs Sign Theory. Leiden: Brill.

Tekoälyn etiikasta keskustellaan tälläkin viikolla mm. Suomi ja tekoäly alustatalouden aikakautena sekä Tekoäly ja filosofia -tapahtumissa.

@Sara_Peltola @ReijoKarhinen @ollirehn Tärkeät huomiot. Innostivat kirjoittamaan siitä, miten #tekoäly’n etiikka ed… https://t.co/1CE3eG0hQw

Eettinen #tekoäly vaatii tunneälyä sekä läpinäkyvyyttä, kirjoittaa @HRydenfelt https://t.co/9Ku8rJnAjc #alustatalous #digitalist

RT @Etiikka: Eettinen #tekoäly vaatii tunneälyä sekä läpinäkyvyyttä, kirjoittaa @HRydenfelt https://t.co/9Ku8rJnAjc #alustatalous #digitali…

RT @Etiikka: Eettinen #tekoäly vaatii tunneälyä sekä läpinäkyvyyttä, kirjoittaa @HRydenfelt https://t.co/9Ku8rJnAjc #alustatalous #digitali…

RT @Etiikka: Eettinen #tekoäly vaatii tunneälyä sekä läpinäkyvyyttä, kirjoittaa @HRydenfelt https://t.co/9Ku8rJnAjc #alustatalous #digitali…

RT @Etiikka: Eettinen #tekoäly vaatii tunneälyä sekä läpinäkyvyyttä, kirjoittaa @HRydenfelt https://t.co/9Ku8rJnAjc #alustatalous #digitali…

RT @Etiikka: Eettinen #tekoäly vaatii tunneälyä sekä läpinäkyvyyttä, kirjoittaa @HRydenfelt https://t.co/9Ku8rJnAjc #alustatalous #digitali…

Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @juhajattu: Tulisiko eettisesti toimiakseen tekoälyllä olla myös tekotunteet? https://t.co/y5AxYQwWes

Henrik Rydenfeltin hyvä kirjoitus #tekoäly ja #tunteet. #tutkimus #työ #koulutus #osaaminen #etiikka https://t.co/YnaAl2J3ul

#Etiikka, #kontrolli ja #valta keskeisiä käsitteitä #AI -keskustelussa. https://t.co/qj53MYqwUL

@villetamminen Mielenkiintoinen juttu aihetta ohuesti sivuten: https://t.co/IvcDIaPuXI

RT @JokinenJari: Henrik Rydenfeltin hyvä kirjoitus #tekoäly ja #tunteet. #tutkimus #työ #koulutus #osaaminen #etiikka https://t.co/YnaAl2J3…

RT @JokinenJari: Henrik Rydenfeltin hyvä kirjoitus #tekoäly ja #tunteet. #tutkimus #työ #koulutus #osaaminen #etiikka https://t.co/YnaAl2J3…

RT @JokinenJari: Henrik Rydenfeltin hyvä kirjoitus #tekoäly ja #tunteet. #tutkimus #työ #koulutus #osaaminen #etiikka https://t.co/YnaAl2J3…

RT @JokinenJari: Henrik Rydenfeltin hyvä kirjoitus #tekoäly ja #tunteet. #tutkimus #työ #koulutus #osaaminen #etiikka https://t.co/YnaAl2J3…

RT @arttu_piri: #Etiikka, #kontrolli ja #valta keskeisiä käsitteitä #AI -keskustelussa. https://t.co/qj53MYqwUL

RT @arttu_piri: #Etiikka, #kontrolli ja #valta keskeisiä käsitteitä #AI -keskustelussa. https://t.co/qj53MYqwUL

RT @arttu_piri: #Etiikka, #kontrolli ja #valta keskeisiä käsitteitä #AI -keskustelussa. https://t.co/qj53MYqwUL

RT @Temuiini: @villetamminen Mielenkiintoinen juttu aihetta ohuesti sivuten: https://t.co/IvcDIaPuXI

RT @arttu_piri: #Etiikka, #kontrolli ja #valta keskeisiä käsitteitä #AI -keskustelussa. https://t.co/qj53MYqwUL

RT @HRydenfelt: @Sara_Peltola @ReijoKarhinen @ollirehn Tärkeät huomiot. Innostivat kirjoittamaan siitä, miten #tekoäly’n etiikka edellyttää…

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @JokinenJari: Henrik Rydenfeltin hyvä kirjoitus #tekoäly ja #tunteet. #tutkimus #työ #koulutus #osaaminen #etiikka https://t.co/YnaAl2J3…

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @JokinenJari: Henrik Rydenfeltin hyvä kirjoitus #tekoäly ja #tunteet. #tutkimus #työ #koulutus #osaaminen #etiikka https://t.co/YnaAl2J3…

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @arttu_piri: #Etiikka, #kontrolli ja #valta keskeisiä käsitteitä #AI -keskustelussa. https://t.co/qj53MYqwUL

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

RT @HRydenfelt: Miten #tekoäly oppisi etiikkaa? Miksi sen täytyy kyetä #viestintä’än ihmisen kanssa?

https://t.co/lAOVbIm9CA

Erinomaista pohdintaa tekoälystä ja etiikasta @HRydenfelt @Etiikka https://t.co/j2fsbV8pkG #viestintä #etiikka

RT @elinamelgin: Erinomaista pohdintaa tekoälystä ja etiikasta @HRydenfelt @Etiikka https://t.co/j2fsbV8pkG #viestintä #etiikka

RT @elinamelgin: Erinomaista pohdintaa tekoälystä ja etiikasta @HRydenfelt @Etiikka https://t.co/j2fsbV8pkG #viestintä #etiikka

etiikka.fi: Voikohan tekoälyllä olla tunteita? Entä miten käy eettisten ongelmien kanssa? https://t.co/VYT7mlDLav

RT @Naskinen: etiikka.fi: Voikohan tekoälyllä olla tunteita? Entä miten käy eettisten ongelmien kanssa? https://t.co/VYT7mlDLav

Tekoäly ja tunteet https://t.co/DSno3ASk6D

RT @SHintsanen: Tekoäly ja tunteet https://t.co/DSno3ASk6D

RT @EevaMariV: Haasteellisia määriteltäviä – #tunneäly #moraali #toimijuus Entäpä #tekoäly llä? Tärkeää pohdintaa @Etiikka https://t.co/ly…

RT @EevaMariV: Haasteellisia määriteltäviä – #tunneäly #moraali #toimijuus Entäpä #tekoäly llä? Tärkeää pohdintaa @Etiikka https://t.co/ly…

Tekoäly on hankala aihe, mutta tämä artikkeli on helppotajuinen ja ajatuksia herättävä. https://t.co/DiSWHKaZJP

RT @SHintsanen: Tekoäly ja tunteet https://t.co/DSno3ASk6D

RT @timoty05: Tekoäly on hankala aihe, mutta tämä artikkeli on helppotajuinen ja ajatuksia herättävä. https://t.co/DiSWHKaZJP

RT @EevaMariV: Haasteellisia määriteltäviä – #tunneäly #moraali #toimijuus Entäpä #tekoäly llä? Tärkeää pohdintaa @Etiikka https://t.co/ly…

Supertekotunneälyä odotellessa https://t.co/XoqzE1OYcM

RT @LLarjo: Supertekotunneälyä odotellessa https://t.co/XoqzE1OYcM

RT @LLarjo: Supertekotunneälyä odotellessa https://t.co/XoqzE1OYcM

Pingback: Konepomo vailla etiikkaa? – Etiikka.fi

@Utopistirealist Kyllä. Jossain määrin kiistaa käydään jo esimerkiksi itseään ajavien autojen kohdalla. Yleensä kes… https://t.co/nZ7bC4M5ai

RT @HRydenfelt: @Utopistirealist Kyllä. Jossain määrin kiistaa käydään jo esimerkiksi itseään ajavien autojen kohdalla. Yleensä keskiössä o…